Những dòng smarphone giúp phổ cập AI tới người dùng cuối

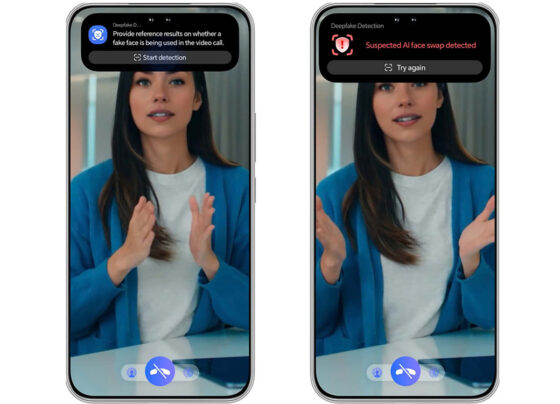

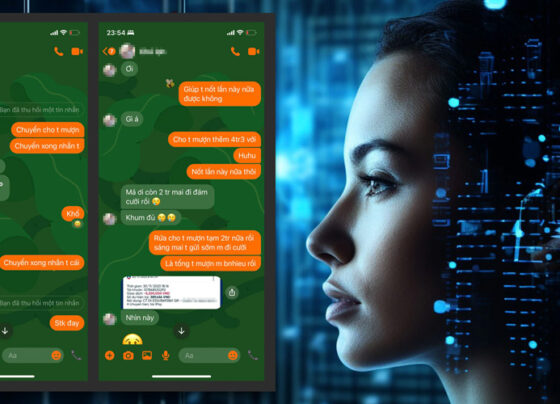

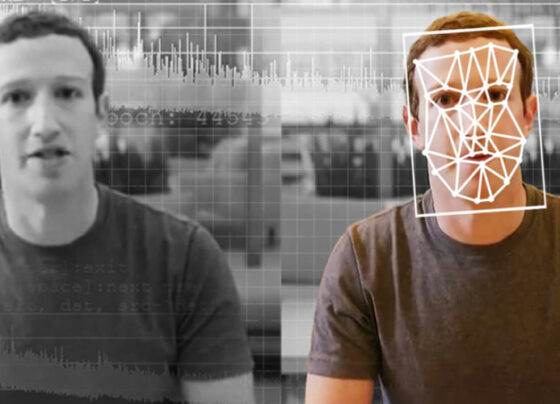

Tích hợp nhiều tính năng bảo mật, phát hiện giả mạo AI để người dùng nhận diện các cuộc gọi video lừa đảo. Cuối quý II/2025, thêm nhiều hãng công nghệ đã đưa AI tạo sinh vào nhiều thiết bị cho phân khúc thị trường phổ thông, mang lại nhiều tiện ích từ AI cho nhiều lĩnh vực trong sinh…